| Issue |

JNWPU

Volume 42, Number 4, August 2024

|

|

|---|---|---|

| Page(s) | 753 - 763 | |

| DOI | https://doi.org/10.1051/jnwpu/20244240753 | |

| Published online | 08 October 2024 | |

Design on temporal-spatial Transformer model for air target intention recognition

面向空中目标意图识别的时空Transformer模型设计

Air and Missile Defense College, Air Force Engineering University, Xi'an 710051, China

Received:

30

June

2023

The battlefield changes rapidly in information warfare. The battlefield situation data presents massive and diversified characteristics, which makes it increasingly difficult to identify the operational intent of air targets based on expert experience. In combination with the current state-of-the-art intelligent methods, the Transformer model is studied and introduced into the field of air target intent recognition for the first time, and a new intent recognition method temporal-spatial transformer(TST) is designed, which can effectively mine the deep feature information in the temporal and spatial domains of battlefield situational data to improve the accuracy of air target combat intention recognition. In addition, a comparative study of the four currently advanced neural network intention recognition methods shows that TST achieved outstanding performance in all indicators and outperformed all compared neural network models. TST method not only has excellent accuracy but also extremely fast convergence rate, which allows it to quickly capture key information from battlefield situation data for intention recognition.

摘要

信息化条件下的战争环境瞬息万变, 战场态势数据呈现海量、多样化的特点, 导致利用专家经验识别空中目标作战意图的难度越来越高。结合目前先进的智能化方法, 对Transformer模型进行研究并将其引入空中目标意图识别领域, 设计出一种新的意图识别方法Temporal-Spatial Transformer(TST), 可以有效地挖掘战场态势数据中时间域和空间域的深层特征信息, 提高空中目标作战意图识别准确率。同时, 对4种目前较为先进的神经网络意图识别方法进行效果对比, 结果表明, TST模型在各类指标上都取得了突出的效果, 优于所有对比的神经网络模型。TST模型不仅有优异的准确率, 而且收敛速度极快, 可以迅速地抓取战场态势数据中的关键信息进行意图识别。

Key words: Transformer / temporal-spatial fusion / air target / inten recognition / self-attention

关键字 : Transformer / 时空融合 / 空中目标 / 意图识别 / 自注意力机制

© 2024 Journal of Northwestern Polytechnical University. All rights reserved.

This is an Open Access article distributed under the terms of the Creative Commons Attribution License (https://creativecommons.org/licenses/by/4.0), which permits unrestricted use, distribution, and reproduction in any medium, provided the original work is properly cited.

This is an Open Access article distributed under the terms of the Creative Commons Attribution License (https://creativecommons.org/licenses/by/4.0), which permits unrestricted use, distribution, and reproduction in any medium, provided the original work is properly cited.

随着科技进步和时代变革, 当今时代的战场态势信息数据具有海量、高增长率、多样化的特点, 导致现代化战场环境的复杂性和信息不对称性呈指数级增长, 未来的战争必然会朝着科技化、信息化不断转变。同时, 战场态势数据信息的规模和维度不断增加, 使得军事领域专家仅仅依靠经验难以从海量的信息数据中及时准确地识别出敌方目标的作战意图, 这一现象加快了智能化技术在态势感知领域中的应用。因此, 我国迫切需要利用前沿智能技术来提高空中目标作战意图识别的准确率。

为了提高对战场态势的信息挖掘能力和军事专家的决策效果, 国内外众多学者针对目标意图识别问题开展了大量研究, 空中目标作战意图识别已成为空战领域的研究热门。传统的空中目标意图识别方法主要有模糊理论、D-S证据理论、模板匹配、模糊推理、贝叶斯网络等方法[1–2]。模糊理论主要分为模糊数学、模糊逻辑与人工智能、模糊系统、不确定性和信息、模糊决策5个分支, 但这5个分支之间有着紧密的联系[3–4]。D-S证据理论属于不确定性推理方法, 最早应用于专家系统中辅助决策[5–6]。模板匹配是最原始的模式识别方法, 通过知识提取得到数据结构,进而构造模板, 利用模板识别出与之具有相同特征的目标[7]。模糊推理以模糊逻辑为基础制定从输入到输出的映射过程, 是不确定推理方法的一种[8]。贝叶斯网络是人工智能领域处理不确定性的主要方法之一, 结合专家知识对目标意图进行推理[9–12]。文献[13]提出了一种模糊置信规则库(BRB)信息处理方法, 根据数据集的分布特点设计了模糊集分割方法, 并建立规则权重和特征权重优化模型, 采用置信度最大原则对目标意图进行识别。但是, 这些传统智能化方法很难用于处理现代战争中规模巨大、指数式增长、来源多样的态势信息数据。目前, 一些学者在多源信息融合和量子决策领域展开了研究, 解决了大规模数据难以处理、分析的问题[14–15]。

近年来, 随着计算机性能不断提升和硬件的迭代更新, 人工智能实现飞跃式发展, 机器学习、深度学习等已成为智能化方法的主要代表。不同的机器学习方法[16–19]已经被应用到空中目标作战意图识别领域之中, 通过机器学习模拟人脑特性的特点, 结合数据驱动, 从战场原始态势数据中提取关键信息, 进一步预测目标意图行为, 克服了传统模型在知识表达方面所面临的困难[20]。文献[21]提出一种GASVM-HMM模型,能够通过飞行员某一动作识别其当前意图以及下一个意图所对应的动作及动作序列。上述文献提出的方法虽然一定程度上解决了面临海量数据场景的难题, 但是机器学习部分操作需要人为干预, 而且算法复杂度比较高, 预测耗时比较长, 因此, 难以很好地处理战场实时变化的复杂信息数据。文献[22]针对机器学习的缺陷, 利用反向传播算法(back propagation, BP), 同时引入ReLU(rectified linear unit)激活函数和自适应矩估计(adaptive moment estimation, Adam)优化算法, 设计了一种基于深度神经网络的空中目标作战意图识别模型, 加快了模型收敛速度, 同时解决了模型陷入局部最优的问题。文献[23]提出一种基于长短时记忆神经网络(LSTM)的空中目标意图识别方法, 对战场数据进行清洗及滑窗处理, 相较于传统方法取得了更好的效果。文献[24]以循环神经网络(recurrent neural network, RNN)作为基础, 融合注意力机制, 对每一个时间步长的隐层单元输出分配差异化权重, 进一步提高模型意图识别的准确率。文献[25]使用注意力机制提取特征信息, 利用时序卷积网络(temporal convolutional network, TCN)深度挖掘数据中潜在的信息, 结合双向门控循环单元(bi-gate recurrent unit, BiGRU)减少历史信息的丢失, 设计了一种基于时序卷积神经网络的空中目标作战意图识别模型, 很好地解决了传统方法难以有效捕获动态战场态势数据的特征信息问题。文献[26]根据作战意图的特点, 设计了一种层次聚合模型, 模型底层利用卷积神经网络感知行为特征, 中间层使用双向长短时记忆网络表达意图内部之间相互依赖关系, 最顶层结合注意力机制提取识别任务中的关键特征, 解决了传统方法无法表达意图的层次性及意图之间长时依赖关系的问题。

根据上述文献发现, 大量的意图识别研究已结合卷积神经网络和循环神经网络的深度学习方法展开, 然而大多卷积和循环神经网络因为其复杂的架构, 所以模型收敛速度较为缓慢。目前, Transformer模型在各领域越演越热, 凭借其出色的性能和简单的架构已成为各领域的研究热门[27]。本文将Transformer方法应用到空中目标意图识别领域, 并提出TST意图识别模型。TST中的自注意力机制(self-attention)能够显著增加对复杂数据的特征信息提取能力, 同时, TST模型拥有从整个输入数据获取信息的能力, 可以准确地建模长距离的依赖关系。而且, TST不仅可以实现并行运算, 能够更好地处理高维态势数据, 提升意图识别的准确率, 同时还使用了一种新的正则化方法——零范数正则化, 将模型中一些不需要的参数压缩, 从而提高模型的泛化能力。由于双塔式架构的特点, TST可以提取时间域和空间域的深层全局特征, 并通过本文提出的Temporal-Spatial Fusion融合机制实现高效融合, 深度挖掘态势数据中的高价值潜藏信息。最后, 通过大量实验结果证明, TST在空中目标作战意图识别领域取得了优异的效果, 超越了目前该领域中一些较为先进的意图识别方法, 对作战辅助系统有较高的参考价值。

1 空中目标意图识别问题描述

空中目标作战意图识别是通过分析战场环境中空中目标动态的、复杂的实时数据, 包括目标的相对距离、速度、高度等, 判定目标状态, 如飞行、逃逸等, 结合深度学习技术、先验知识、相关作战领域专家经验等高效、精准地推理出敌方空中目标状态及目标意图。

定义向量ST为连续时间T秒内的空中目标作战实时特征集, 由t1到tT时刻的实时特征信息组成, 可以表示为

定义向量Q为空中目标作战意图空间集, 在实际空中战场环境中, 敌方目标的行动受到多种因素影响, 很容易进行误导和欺骗, 因此单一时刻识别敌方作战意图可能不够准确和可靠。相比较而言, 通过分析敌方空中目标在多个连续时刻的特征信息, 推测其作战意图的准确度和科学性会更高[20]。因此, 可以确定空中目标作战特征集到空中目标作战空间集的映射函数如(2)式所示

显然, 如果要准确识别空中目标作战意图, 需要结合空战专家的军事知识和经验, 进行复杂的信息提取、分析和推理等思维活动, 这个过程不是简单的数学运算, 无法用单一的数学公式来建立目标特征和目标意图之间的映射关系[28]。为此, 本文通过搭建TST神经网络模型并加入空中目标作战意图特征集来训练, 建立了目标特征与目标意图之间的映射关系。空中目标意图识别整体流程如图 1所示。

|

图1 空中目标作战意图识别过程 |

1.1 空中目标作战意图空间描述

不同的作战环境、作战形式、敌方作战目标所对应的目标意图空间都有不同的特点。如陆光宇等[29]根据水下目标所具备的属性以及作战环境等定义目标意图空间为{撤离, 攻击, 巡逻}; 陈浩等[4]针对海上战舰编队, 建立的目标意图空间为{撤退,掩护,攻击,侦察}; 马钰棠[30]根据空中目标作战特点建立的目标意图空间为{攻击,佯攻,撤退,侦察,监视,电子干扰}。本文结合空中目标作战环境、空中目标作战的属性, 定义目标意图空间为{进攻,突防,警戒,侦察,佯攻,后撤,电子干扰}。

1.2 空中目标作战意图识别特征描述

通常, 敌方空中目标执行的任务、任务针对的对象以及一些特定的战术动作都与目标的意图密切相关。为了清晰直观地表现出敌方目标的行为意图, 本文根据空战领域专家经验和与目标意图相关联的条件选取空中目标作战特征。

从敌方空中目标作战执行的任务角度进行分析, 空中目标作战执行不同任务时, 目标的行为、所具备的条件都有所不同。例如, 当歼击机、运输机和轰炸机执行突防攻任务时, 其飞行速度都存在差异, 歼击机通常会以大速度接敌, 飞行速度一般为735~1 470 km/h; 运输机和轰炸机的飞行速度为600~850 km/h[22]。同样以执行突防任务为例, 空战目标一般有低空突防和高空突防2种形式, 低空突防一般为50~200 m, 高空突防一般为10 000~11 000 m; 如果目标执行侦察任务, 目标的侦察形式分为低空侦察和超高空侦察, 飞行高度分别为100~1 000 m及15 000 m以上[22]。

此外, 空中目标作战执行攻击、突防任务时, 通常会开启电子干扰及对空雷达; 执行侦察任务时, 通常会开启对空雷达及对海雷达[31]。在战场环境不断变化和目前对空战目标类型识别的研究较为薄弱的情况下, 本文采用雷达的反射截面积大致判断空战目标类型, 若反射截面积小于1 m2, 空战目标可以大致确定为小型战机或隐身战机; 若反射截面积为1~10 m2, 则为中型战机; 大型战机的雷达反射截面积通常大于10 m2。

结合空战领域专家经验, 在战场环境中能实时采集到的数据主要有空中作战目标飞行速度、高度、加速度、航向角、方位角及相对距离。

除此之外, 空战能力因子及携带武器特征也是不容忽略的外部特征, 对于空战目标的作战能力, 本文结合李战武和欧爱辉等[32–33]对空战能力的评估方法, 构建出空战能力因子评估函数

式中:α1, α2, α3, α4分别表示战机操作性能、战机航行能力、战机生存能力及电子干扰对抗能力; β1, β2, β3分别表示战机机动能力、机载探测器性能、机载武器能力。不同战机的空战能力因子也有所不同, 可以将相同战机的空战能力因子计算后保存, 并根据情报数据定期更新[34]。

空战目标携带武器特征主要以识别是否携带武器为主, 携带武器的空战目标则可以划分为:①高威胁目标, 可能有攻击意图; ②未携带武器的目标,以侦察、电子干扰意图为主。

综上, 本文共选取12种关键意图特征, 包括4种非数值型意图特征和8种数值型意图特征, 如表 1~2所示。

其中, 方向角和航向角都以正北方向均设为0°。

数值型空中目标特征

非数值型空中目标特征

2 意图识别模型描述

本节详细地介绍了本文提出的TST模型的总体结构。TST是基于Transformer模型的时空融合意图识别方法, Transformer模型最近在自然语言处理和计算机视觉领域的各种任务都取得了前沿性的优势。受Transformer模型在众多领域表现优异的启发, 本文将Transformer引入到空中目标作战意图识别领域, 并设计为双塔式架构分别提取态势数据中的深层时间特征和空间特征, 再利用时空融合模块进一步提取特征中的有效信息, 提高意图识别性能并取得了优异的效果。

2.1 TST模型整体框架

本文提出的TST模型主要由三部分组成, 即Temporal-Encoder模块、Spatial-Encoder模块和Temporal-Spatial Fusion模块,具体架构如图 2所示。TST使用Transformer框架中的编码器(Encoder)部分提取时间序列特征; Temporal-Transformer和Spatial-Transformer都是由堆叠的编码器组成, 分别用以提取时间域和空间域的深层全局特征, 然后由Temporal-Spatial Fusion模块将时间特征和空间特征进行融合和识别。

|

图2 TST模型框架图 |

2.2 Encoder架构

Encoder是Transformer的重要组成模块, 通常由多头注意力机制(multi-head attention)、前馈网络(feed forward network)、归一化(layer normalization)和残差连接(residual connections)组成。

图 2右侧部分展示了多头注意力机制的结构。模型通过多头注意力机制可以基于相同的注意力机制学习到H组不同的线性投影, 然后并行地传入注意力机制, 最后融合到一起以产生最终的输出。其过程描述如下。

输入序列Y被映射为查询向量矩阵Q、键向量矩阵K和值向量矩阵V经过注意力机制得到的权重矩阵W∈Rn×n, 这个过程被定义为

式中, dH表示多头注意力机制的维度H。

通过注意力权重矩阵对值向量矩阵V进行加权后, 经过单个注意力机制得到的输出为

多头注意力机制将每一个注意力机制的输出并在一起, 其过程如下

式中:WH∈RH×dH×dm为权重矩阵;dm表示向量的维度; IMH(Q, K, V)表示多头注意力机制的输出。

多头注意力机制通过线性映射将嵌入有位置信息的高维向量序列Y映射为Q, K, V。然后, 通过Q和K计算特征之间的相关性, 得到注意力权重矩阵。再利用注意力矩阵对V进行加权, 得到单头注意力机制的输出, 最后对单头注意力机制的输出进行合并, 得到多头注意力机制的输出。

多头注意力机制得到的输出经过Dropout层、残差连接和归一化处理后与输入融合作为前馈网络层的输入。通常, 前馈网络包含3层, 第1层的作用是将输入映射到高维空间, 第2层通过非线性激活层增强特征的非线性表示, 第3层则进行降维, 过程描述为

式中, W1∈Rdm×dFFN, W2∈RdFFN×dm表示2层维度变换的权重矩阵。LN则表示归一化函数, OFFN为前馈神经网络层的输出。

FFN得到的输出再经过Dropout层、残差连接和归一化处理后, 得到Encoder的输出, 其过程为

以上是单个编码器的输出, 堆叠的编码器是串联连接的, 将前一个编码器的输出作为输入, 最终的输出就是输入序列的深层全局特征。

2.2.1 Temporal-Encoder模块

为了提取输入序列中的时间特征, TST使用带有掩码的自注意力, 通过计算所有时间步长之间的成对注意力权重来关注所有通道上的每个点, 同时, 在多头注意力层中所有时间步长上形成注意力矩阵。与原始的Transformer架构一样, 位置编码的全连接前馈网络层堆叠在每个多头注意力层上, 用于增强特征提取。2个子层中的残差连接引导信息和梯度流, 随后进行层归一化。Temporal-Encoder通过提取动态时间变化信息来有效地表示全局时间关系, 而且Temporal-Transformer(T-T)由N层编码器组成, 可以挖掘出序列的深层特征。总之, Temporal-Transformer可以有效提取时间特征的深层全局信息, 同时作为空间特征信息的补充, 提高目标意图识别准确率。

2.2.2 Spatial-Encoder模块

类似地, Spatial-Encoder可以跨所有时间步长计算不同空间特征之间的注意力权重。通常, 真实场景中提取得到的态势数据信息包含大量的噪声区域, Spatial-Encoder可以有效地提取序列中的全局空间特征信息, 并大幅降低序列中噪声区域的影响。Spatial-Encoder通过计算距离单元之间的长距离相关性来对距离单元之间的空间相关性进行建模, 从而自适应地提取目标区域的空间信息并抑制噪声区域的影响。此外, Spatial-Transformer(S-T)同样包括N层编码器, 可以有效地挖掘序列中的空间特征信息。

2.2.3 Temporal-Spatial Fusion模块

为了融合Temporal-Encoder和Spatial-Encoder提取的特征信息, 本文使用Add & Concatenate融合方法作为Temporal-Spatial Fusion(T-S F)模块。

输入的高维向量序列Y通过堆叠的Encoder可以提取其中的深度全局特征, 其中Temporal-Encoder输出时间全局特征ΘT, Spatial-Encoder输出空间全局特征ΘS, 然后再通过Temporal-Spatial Fusion实现时间特征ΘT和空间特征ΘS的融合, 其通过注意力机制权重的计算过程如下

为了实现时空融合, 使用注意力权重矩阵AF对时间和空间特征加权, 然后融合的特征为

虽然时间和空间的全局特征信息都能用于识别任务, 但仅通过简单的方法连接2个Transformer的特征, 反而会损害两者的性能。本文的融合方法加入了注意力机制, 可以有效地学习2个特征之间的相关性, 从而可以自适应地为时间和空间全局特征分配权重, 实现更高效的融合。

3 实验分析

3.1 性能评价指标

为评价本文提出的TST空中目标作战意图识别模型性能优劣, 采用准确率(accuracy), 精确率(precision), 召回率(recall), F1-分数(F1-score), 损失值(Loss)作为评价指标。

在目标意图识别任务中, 计算某一意图行为的准确率、精确率、召回率、F1分数、损失值时, 该意图行为所有的标注样本为正例, 其他意图为负例。准确率、精确率、召回率、F1-分数、损失值的计算方式分别为

式中:PT为正确分类的正例;NF为错误分类的负例;PF为错误分类的正例;NT为正确分类的负例。(15)式中, pi表示真实标签的概率, qi表示预测标签的概率。

3.2 实验数据与环境

实验中所使用的数据集来源于Air Combat Maneuvering Instrumentation(ACMI)作战仿真系统, 由空战领域专家对其标签进行修订。数据集包括8 400个训练样本和2 100个测试样本, 共10 500个样本, 每个样本数据包含连续12帧信息, 每帧信息包括12个维度的特征信息。实验使用Python3.7语言, 在GPU和CUDA12.1加速环境下运行, 采用Pytorch1.12.1深度学习框架, 实验中使用的操作系统是Windows11, 硬件配置是Inter®Xeon®Silver 4214R CPU、NVIDIA A100 80GB PCIe显卡、128G内存。

3.3 数据输入

由于战场态势数据多样复杂, 传感器捕捉到的数据来自不同机型的不同特征状态, 例如, 一些战机攻击意图的飞行高度为1 000~6 000 m。不同数值型特征的单位和数值差异较大, 会影响TST模型的收敛效率和准确率, 为此, 本文对数据进行了min-max标准化处理

式中: Xi表示第i种数值型特征; xin表示第i种数值型特征的第n个原始值, max Xi表示第i种数值型特征的最大值。经过min-max标准化处理后, 每种数值型特征的原始值都被映射到区间[0, 1], 显著降低了数值型特征由于方差大导致的影响。

3.4 实验结果与分析

3.4.1 TST模型结果分析

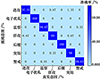

TST模型测试集和训练集的准确率和损失值结果如图 3所示。在训练次数为20左右时,模型达到收敛状态, 此时训练集的准确率达到100%并保持稳定; 训练集的损失值在0.000 03上下浮动, 最低可达0.000 026;测试集的准确率在99%上下浮动, 最高可达99.15%;测试集的损失值在0.007上下浮动, 最低可达0.005 7。

为了进一步分析模型的意图识别结果在各意图下的具体情况, 绘制了测试集的混淆矩阵, 如图 4所示, 混淆矩阵的对角线表示识别的正确率。根据图中的结果, 可以看出本文所提模型对7类意图的识别准确率都较高, 但在识别进攻/佯攻/突防的意图类别上, 模型将小部分样本识别错误, 导致错分情况的原因是这3类意图对应的样本特征相似度较高。总体来看, 模型对后撤的意图识别精度最高, 对其余6类意图也有较高的识别准确率, 而且准确率已经超过了现有的识别方法, 能在一定程度上减少战时指挥员的压力。

|

图3 TST模型训练和测试的准确率和损失值 |

|

图4 TST模型意图识别结果的混淆矩阵 |

3.4.2 模型消融实验分析

消融实验结果如表 3所示,其中Add是指仅通过简单的连接来融合Temporal-Transformer和Spatial-Transformer的输出。同时通过计算各模型的精确率、召回率及F1-分数3种评价指标对比分析每类意图的反应情况,如表 4所示。

根据上述结果可以分析出, TST模型性能十分优越, 在准确率和损失值的表现也非常突出。同时, TST在精确率、召回率及F1-分数的表现相比融合前的Transformer更加优异, 进一步证明了通过Temporal-Sptial Fusion将Temporal-Transformer和Spatial-Transformer结合得到的TST能够在意图识别领域发挥独特的优势。

从消融实验结果能够看出, Temporal-Transformer的表现不如Spatial-Transformer, 为了进一步验证时间步长对TST的影响, 本文根据数据集的特点, 选取不同时间步长作为对比, 结果如表 5所示。

将时间步长分别调整为12, 6和1来验证其对准确率的影响。通过表 5结果可以发现, 时间步长的缩短对TST准确率的影响比较小。同时, 说明样本空间特征的影响大于时间特征对TST准确率的影响。

消融实验结果

消融实验中各评价指标结果

时间步长对TST准确率的影响

3.4.3 各模型对比实验分析

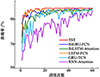

为了证明TST模型性能的优越性, 现使用准确率较高的多种先进模型对比意图识别结果的准确率及损失值。对比模型包括文献[35]所提的基于GRU的FCN空中目标意图识别方法; 文献[36]的BiLSTM-Attention空中目标意图识别模型; 文献[37]的基于BiGRU模块结合注意力机制的TCN意图识别模型; 文献[38]提出了基于LSTM的空中目标意图识别模型, 本文在此基础上加入了FCN神经网络, 以提高可比性; 为了进一步验证TST时空自注意力机制的效果, 本文引入了循环神经网络(RNN)结合时空注意力机制进行对比, 对比结果如表 6所示。

通过以上实验结果, 可以观测出TST在空中目标意图识别领域的优越性, 该模型的准确率不仅超越了目前一些先进的空中意图识别模型, 还能迅速高效地收敛得到最优结果。同样, 如表 7所示,本文所提的模型在损失值、精确率、召回率、F1-分数的表现上也优于各对比模型, 不仅能快速降低损失值, 最低能达到0.005 7, 而且在精确率、召回率、F1-分数都表现优异。

根据图 5可以发现, TST相较于其他对比模型收敛速度最快, 为了进一步证明TST收敛的快速性, 本文将各对比模型的参数量与收敛所需时间同TST进行了对比, 结果如表 8所示。

表 8结果都是在与TST相同环境和参数设置下得出的, 因此, 部分模型在此条件下收敛速度较为缓慢。从表 8中可以看出, TST模型参数量相比其他模型规模更大, 但是经过20轮的训练就能够达到收敛状态, 同时训练耗费的时间也是最短的。总体来说, TST模型表现出了优越的性能。

各对比模型意图识别准确率和损失值

对比实验中各评价指标结果

|

图5 各对比模型准确率结果 |

模型参数量、收敛轮数及训练时长比较

4 结论

1) 针对传统卷积和循环神经网络模型架构复杂、处理时序问题训练时间过长、模型收敛速度缓慢、容易陷入局部最优, 以及在处理长序列数据时存在记忆衰退现象, 容易丢失序列中重要信息的问题, 本文将Transformer方法引入到空中目标意图识别领域, 并设计了一种TST模型,该模型可以实现并行运算, 能够更好地处理高维态势数据, 提高意图识别的准确率, 而且相比其他模型能够迅速收敛, 达到最佳效果。

2) 由于具有双塔式架构, TST可以有效地挖掘战场态势数据中时间域和空间域的深层特征信息, 能够进一步提取战场态势数据中蕴藏的目标真实意图的关键特征。同时, 本文通过实验与目前比较先进的卷积神经网络和循环神经网络模型进行效果对比,并进行了自身的消融实验验证, 结果表明, TST在各方面指标都能够取得优异的效果, 对辅助指挥员进行指挥决策及应对突发情况具有参考意义。

在未来的工作中, 将对模型进行优化使其能够有效辨别欺骗性意图和相似意图, 并将其设计为轻量化的TST, 在不影响性能的同时, 缩减其参数量, 进一步提升训练速度。此外, 大多现有研究都是基于有监督的学习方式来训练模型, 数据标签大多由空战领域专家所制订,可能会存在误判的情况,导致训练的模型也会识别错误, 考虑无监督或者半监督学习方式可能会使意图识别结果更加准确。

References

- WANG Haiwang, SHI Hongquang, ZHAO Xiaozhe. A summary of target intent identification methods[C]//2020 China System Simulation and Virtual Reality Technology Forum, Beijing, 2020: 3 (in Chinese) [Google Scholar]

- GONG Cheng, YI Junbo, CAI Lingong, et al. Intelligent recognition method of target intention based on knowledge graph embeddeed learning[J]. Ship Electronic Engineering, 2023, 43(1): 32–35. [Article] (in Chinese) [Google Scholar]

- ZHANG Su, CHENG Qiyue, XIE Yao, et al. A method of inference intention with uncertain aerial information[J]. Journal of Air Force Engineering University, 2008(3): 50–53. [Article] (in Chinese) [Google Scholar]

- CHEN HAO, REN Qinglong, HUA Yi, et al. Fuzzy neural network based tactical intention recognition for sea targets[J]. System Engineering and Electronics, 2016, 38(8): 1847–1853 (in Chinese) [Google Scholar]

- SUN Yuelin, BAO Lei. Study on recognition technique of targets' tactical intentions in sea batlefield based on D-S evidence theory[J]. Ship Electronic Engineering, 2012, 32(5): 48–51. [Article] (in Chinese) [Google Scholar]

- ZHANG Yu, DENG Xinyang, LI Mingda, et al. Air target intention recognition based on evidence-network causal analysis[J]. Acta Aeronautica et Astronautica Sinica, 2022, 43(suppl): 143–156 (in Chinese) [Google Scholar]

- XIA Xi. The study of target intention assessment method based on the template-matching[D]. Changsha: National University of Defense Technology, 2006 (in Chinese) [Google Scholar]

- XU Jianping, ZHANG Lifan, HAN Deqiang. Air target intention recognition based on fuzzy inference[J]. Command Information System and Technology, 2020, 11(3): 44–48 (in Chinese) [Google Scholar]

- GENG Zhenyu, ZHANG Jiankang. Research on air target combat intention inference based on bayesian networks[J]. Modern Defence Technology, 2008, 36(6): 40–44. [Article] (in Chinese) [Google Scholar]

- WANG Hongran. Research on air target intention recognition based on multi-entities bayesian networks[D]. Changsha: National University of Defense Technology, 2011 (in Chinese) [Google Scholar]

- YU Zhenxiang, HU Xiaoxuan, XIA Wei. Foe intention inference in air combat based on fuzzy dynamic Bayesian network[J]. Journal of Hefei University of Technology, 2013, 36(10): 1210–1216. [Article] (in Chinese) [Google Scholar]

- ZHANG W, YANG F, LIANG Y. A Bayesian framework for joint target tracking, classification, and intent inference[J]. IEEE Access, 2019, 7: 66148–66156. [Article] [NASA ADS] [CrossRef] [Google Scholar]

- WANG Haibin, GUAN Xin, YI Xiao, et al. An intention recognition method based on fuzzy belief-rule-base[J]. Journal of Electronics & Information Technology, 2023, 45(3): 941–948 (in Chinese) [Google Scholar]

- XU Yibo, YU Qinghua, WANG Yanjuan, et al. Ground target recognition and damage assessment of patrol missiles based on multi-source information fusion[J]. Journal of System Simulation, 2023, 36(2): 511–521 (in Chinese) [Google Scholar]

- FUYUAN X, WITOLD P. Negation of the quantum mass function for multisource quantum information fusion with its application to pattern classification[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2022, 45(2): 2054–2070 [Google Scholar]

- HU Zhiyong, LIU Huali, GONG Shujun, et al. Target intention recognition based on random forest[J]. Modern Electronic Technology, 2022, 45(19): 1–8 (in Chinese) [Google Scholar]

- YANG Yutian, YANG Jie, LI Jianguo. Research on air target tactical intention recognition based on EMEBN[J]. Fire Control & Command Control, 2022, 47(5): 163–170. [Article] (in Chinese) [Google Scholar]

- LIU Shitong. Research and application of air target intent recognition technology based on machine learning[D]. Chengdu: University of Electronic Science and Technology, 2022 (in Chinese) [Google Scholar]

- WU Guangyu, SHI Hongquan, QIU Chuchu. Intention recognition method of air target based on SSA-SVM[J]. Ship Electronic Engineering, 2022, 42(3): 29–34. [Article] (in Chinese) [Google Scholar]

- OU Wei, LIU Shaojun, HE Xiaoyuan, et al. Study on the intelligent recognition model of enemy target's tactical intention on battlefield[J]. Computer Simulation, 2017, 34(9): 10–14. [Article] (in Chinese) [Google Scholar]

- JIANG Jiayun, SUN Youchao, YAN Chuanqi. Pilot manipulation intention recognition based on GASVM-HMM algorithms[J]. Aeronautical Computing Technique, 2023, 53(1): 43–47 (in Chinese) [Google Scholar]

- ZHOU Wangwang, YAO Peiyang, ZHANG Jieyong, et al. Combat intention recognition for aerial targets based on deep neiral network[J]. Acta Aeronautica et Astronautica Sinica, 2018, 39(11): 200–208 (in Chinese) [Google Scholar]

- QIAN Zhao, LIU Qin, LU Yao, et al. Identification of target's combat intention based on long short term memory network[J]. Journal of Terahertz Science and Electronic Information Technology, 2022, 20(11): 1156–1162. [Article] (in Chinese) [Google Scholar]

- WU Nanfang. Research on cluster intention recogniton method based on reccurent neural network[D]. Chengdu: Southwest Jiaotong University, 2019 (in Chinese) [Google Scholar]

- TENG Fei, XING Qianli, WANG Longfei, et al. A model for aerial target intention recognition based on TCN[C]//2022 China Automation Conference, Xiamen, 2022: 8 (in Chinese) [Google Scholar]

- LI Ying, WU Junsheng, LI Weigang, et al. A hierarchical aggregation model for identifying operational intent[J]. Journal of Northwestern Polytechnical University, 2023, 41(2): 400–408. [Article] (in Chinese) [NASA ADS] [CrossRef] [EDP Sciences] [Google Scholar]

- SINGH S, MAHMOOD A. The NLP Cookbook: modern recipes for transformer based deep learning architectures[J]. IEEE Access, 2021, 9: 68675–68702. [Article] [CrossRef] [Google Scholar]

- OU Wei, LIU Shaojun, HE Xiaoyuan, et al. Tactical intention recognition algorithm based on encoded temporal features[J]. Command Control and Simulation, 2016, 38(6): 36–41 (in Chinese) [Google Scholar]

- LU Guangyu, DING Yingying. Study on intention recognition to foe of underwater platform[J]. Command Control and Simulation, 2012, 34(6): 100–102 (in Chinese) [Google Scholar]

- MA Yutang, SUN Peng, ZHANG Jieyong, et al. Air group intention recognition method under imbalance samples[J]. Systems Engineering and Electronics, 2022, 44(12): 3747–3755 (in Chinese) [Google Scholar]

- LIU Zhuandong, CHEN Mou, WU Qingxian, et al. Prediction of unmanned aerial vehicle target intention under incomplete information[J]. Scientia Sinica Informationis, 2020, 50(5): 704–717 (in Chinese) [CrossRef] [Google Scholar]

- LI Zhanwu, CHANG Yizhe, YANG Haiyan, et al. Situation assessment method for cooperative air combat based on dynamic combat power field[J]. Journal of System Simulation, 2015, 27(7): 1584–1590 (in Chinese) [Google Scholar]

- OU Aihui, ZHU Ziqian. A Method of threat assessment based on MADM and results of situation assessment in air to air combat[J]. Fire Control Radar Technology, 2006(2): 64–67 (in Chinese) [Google Scholar]

- XI Zhifei, XU An, KOU Yingxin, et al. Target threat assessment in air combat based on PCA-MPSO-ELM algorithm[J]. Acta Aeronautica et Astronautica Sinica, 2020, 41(9): 216–231 (in Chinese) [Google Scholar]

- DING Peng, SONG Yafei. A cost-sensitive method for aerial target intention recognition[J]. Acta Aeronautica et Astronautica Sinica, 2023, 44(24): 176–191 (in Chinese) [Google Scholar]

- TENG Fei, LIU Shu, SONG Yafei. BiLSTM-Attention: an air target tactical intention recognition model[J]. Aero Weaponry, 2021, 28(5): 24–32 (in Chinese) [Google Scholar]

- TENG F, SONG Y F, GUO X P. Attention-TCN-BiGRU: an air target combat intention recognition model[J]. Mathematics, 2021, 9(19): 2412 [CrossRef] [Google Scholar]

- XUE J, ZHU J, XIAO J, et al. Panoramic convolutional long short-term memory networks for combat intension recognition of aerial targets[J]. IEEE Access, 2020, 8: 183312–183323 [CrossRef] [Google Scholar]

All Tables

All Figures

|

图1 空中目标作战意图识别过程 |

| In the text | |

|

图2 TST模型框架图 |

| In the text | |

|

图3 TST模型训练和测试的准确率和损失值 |

| In the text | |

|

图4 TST模型意图识别结果的混淆矩阵 |

| In the text | |

|

图5 各对比模型准确率结果 |

| In the text | |

Current usage metrics show cumulative count of Article Views (full-text article views including HTML views, PDF and ePub downloads, according to the available data) and Abstracts Views on Vision4Press platform.

Data correspond to usage on the plateform after 2015. The current usage metrics is available 48-96 hours after online publication and is updated daily on week days.

Initial download of the metrics may take a while.